Künstliche Intelligenz – der neue Lügendetektor?Understanding Digital Capitalism III | Teil 9

26.3.2018 • Gesellschaft – Text: Timo Daum, Illustration / Infografik: Susann Massute

Alexa nach dem Wetter zu fragen, ist die eine Sache. Der Künstlichen Intelligenz und den proprietären Algorithmen privater Unternehmen Entscheidungen und Analysen im Justizwesen zu übereignen, ist eine andere. Doch genau das geschieht bereits – weltweit. Ist die KI der neue und vermeintlich bessere Lügendetektor? Oder doch nur eine digitale Diskriminierungsmaschine?

Was bisher geschah

Maschinelles Lernen von neuronalen Netzen benötigt eine große Menge an Daten, um daraus Muster zu erkennen. Künstliche-Intelligenz-Software trainiert sich selbst mit diesen Daten – ähnlich wie wir lernen, Hunde und Katzen zu erkennen, indem wir sehr viele von ihnen zu Gesicht bekommen. Zu den Problemen, die mit solcher Software gelöst werden können, gehören neben Rechtschreibkorrektur, Bild- und Spracherkennung auch selbständig agierende Systeme wie sie etwa beim autonomen Fahren zum Einsatz kommen. KI-Systeme kommen aber auch vermehrt zum Einsatz, wenn es darum geht, Bewerberinnen und Bewerber auszusortieren oder die Wahrscheinlichkeit zu bestimmen, mit der Menschen ihre Kredite abbezahlen, bestimmte Produkte kaufen oder Verbrechen begehen.

„Technologie ist weder gut noch schlecht, und sie ist ganz bestimmt nicht neutral.“

(Erstes Gesetz des Technikhistorikers Melvin Kranzberg)

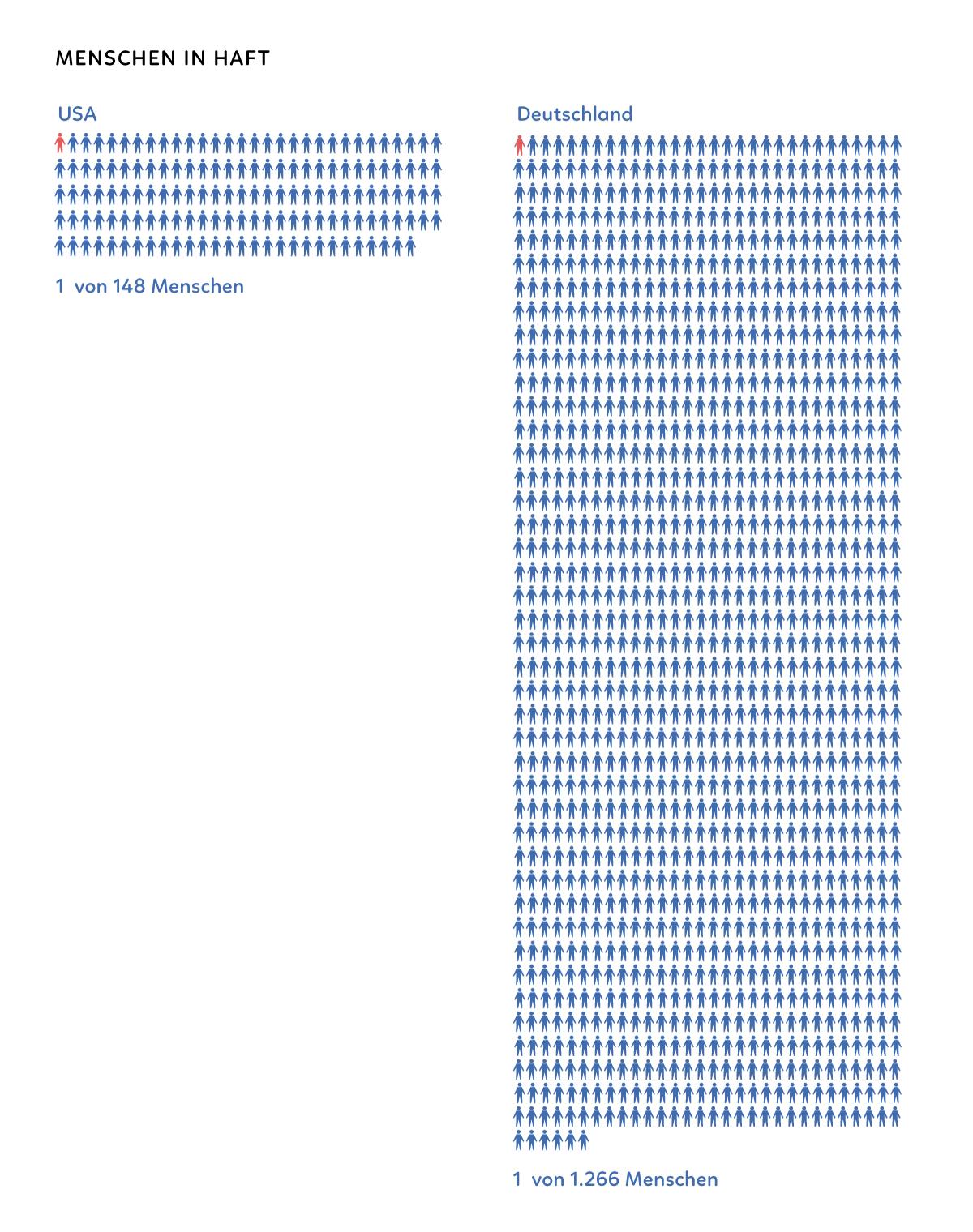

Justizwesen als lukratives Geschäft

Insbesondere in den USA ist das System aus Strafverfolgung, Rechtsprechung und Gefängniswesen eine Branche, in der Milliarden umgesetzt werden. Eine Untersuchung der Obama-Administration stellt für das Jahr 2016 fest: „Insgesamt sind etwa 2,2 Millionen US-Amerikanerinnen und US-Amerikaner hinter Gittern, dabei ist der Anteil der Inhaftierten an der Gesamtbevölkerung 4,5 mal größer als noch 1980.“ Schwarze sind überrepräsentiert: Von 100.000 Einwohnern befinden sich 676 im Gefängnis, davon sind 40 Prozent schwarz, obwohl der Anteil der Schwarzen an der Gesamtbevölkerung nur 13 Prozent beträgt. Laut Daten des Justizministeriums für 2015 befinden sich allerdings – rechnet man diejenigen dazu, die auf Bewährung draußen (probation) oder Freigänger sind (parole) – weit mehr Menschen in den Mühlen des Justizsystems, nämlich über 6,7 Millionen. Zum Vergleich: In Deutschland befanden sich im August 2017 64.223 Gefangene und Verwahrte in Justizvollzugsanstalten, das ist ca. einer auf 1.300 Einwohner. Um auf US-Niveau zu kommen (jeder 148.), müssten über eine halbe Million (520.000) zusätzlich eingesperrt werden.

Die Automatisierung des Rechts

Das Justizsystem ist nicht nur ein wichtiger Wirtschaftszweig, sondern aufgrund der schieren Masse an Verfahren ein bevorzugtes Feld für Rationalisierung und so auch eines der vorrangigen Experimentierfelder für Künstliche Intelligenz. Wer US-amerikanische Gerichts-Serien schaut, weiß, dass das dortige Justizsystem zudem ein Klassensystem ist. In der ersten Folge der siebten Staffel der hervorragenden Serie „The Good Wife“ gerät Star-Anwältin Alicia Florick, die sonst Upper-Class-Kunden gewohnt ist, in die Niederungen des Bond-Courts. Hier werden Kautions-Anhörungen im 90-Sekunden-Takt abgearbeitet, die Anwältinnen und Anwälte verdienen pauschal 135 Dollar pro Fall. Viele der in Anzug oder Kostüm verrichteten Tätigkeiten sind leicht durch Software zu ersetzen. Nach einer Studie der Unternehmensberatung McKinsey könnten 23 Prozent der Tätigkeiten in der Rechtsprechung automatisiert werden.

In Großbritannien werden Verkehrsdelikte heute bereits automatisch sanktioniert.

Auch der Rechtsprofessor Javier de Cendra, Dekan der IE Law School in Madrid, ist überzeugt: „Bereits die Hälfte aller Anwaltstätigkeiten können heute automatisiert werden.” Er betont, dass es sich bei vielen Tätigkeiten um „mechanische Arbeiten“ handelt, deren anwendbare Kriterien nicht von menschlicher Entscheidungsfähigkeit abhängen, sondern rein von einem durch das Gesetz vorgegebenen Prozess. In Großbritannien werden etwa Verkehrsdelikte, bei denen die Sanktion in einfacher Weise mit dem Vergehen verknüpft ist, automatisch prozessiert: 20 km/h zu schnell entspricht 20 Pfund Sterling. Ein Kinderspiel für einen Algorithmus, der ja in Alan Turings Modell nichts anderes ist als ein symbolverarbeitendes Fließband.

Schon Max Weber wusste: Ein Richter ist nichts anderes als eine Turing-Maschine.

Schon die Klassiker der Soziologie hatten das erkannt: So beschreibt etwa Max Weber den Richter in seiner Tätigkeit als Automaten, in welchen die konkreten Fälle eingespeist werden (Input), worauf er diese prozessiert in mechanischer Anwendung des Regelwerks der Gesetze und schließlich das Urteil ausgibt (Output). Das Recht verkörpert hier den Algorithmus, der konkrete Fall stellt die Daten dar, und der Richter bildet die Inkarnation einer Maschine, die den Algorithmus abarbeitet – der Richter als Turing-Maschine! Die Schweizer Soziologin Bettina Heintz schreibt: „Formale Rationalität ist in den Augen von Max Weber das grundlegende Strukturprinzip der modernen abendländischen Gesellschaft. Berechenbarkeit und Orientierung an allgemeinen Regeln kennzeichnen das moderne Recht, die (staatliche) Bürokratie und den kapitalistischen Betrieb, um nur die drei Hauptbereiche formaler Rationalisierung zu erwähnen.“

Foto: equivant

KI und richterliche Entscheidungen

Und dabei geht es nicht um Alltagstätigkeiten im Büro: AnwältInnen und RichterInnen sollen in Zukunft mit Hilfe von Algorithmen ihre Arbeit effizienter durchführen, ihre Fälle auf Basis einer breiten Datengrundlage bearbeiten und mit fundierten Argumenten gewinnen. Big Data und Künstliche Intelligenz halten Einzug in die Rechtsprechung. Insbesondere bei der Gewährung von Kaution oder Aussetzung von Untersuchungshaft und Entscheidungen über gelockerte Haftbedingungen treffen Richterinnen und Richter Entscheidungen, die oft genug von Zufällen, Erfahrung (sprich: Äußerlichkeiten wie Hautfarbe) und einer dünnen Datenbasis abhängig sind. Kann Software hier helfen, frei von Vorurteilen (Bias) und mit mehr Daten bessere Entscheidungen zu treffen?

In einer Studie des National Bureau of Economic Research trainierten Ökonomen und Computerwissenschaftler einen Algorithmus, um anhand von Daten aus Hunderttausenden Strafregister- und Gerichtsakten in New York City zu prognostizieren, ob bei Angeklagten ein Fluchtrisiko besteht. Bei mehr als 100.000 weiteren Fällen erwies sich der Algorithmus als besser geeignet, um vorherzusagen, was die Angeklagten nach der Entlassung tun werden, so die Ergebnisse.

Private Algorithmen, Black Boxes

Viele Firmen bieten mittlerweile Software an, die Richterinnen und Richtern Entscheidungshilfen an die Hand gibt. Am bekanntesten ist vielleicht die Firma equivant und ihr Programm „Compas“ (Correctional Offender Management Profiling for Alternative Sanctions) – das Microsoft Office der KI-gestützten Rechtsprechung sozusagen. Die Software ist proprietär und wird lizenziert, das bedeutet, dass der Code nicht quelloffen ist, die Algorithmen Geschäftsgeheimnis bleiben und die Software insgesamt zur Black Box wird. Nur der Eigentümer der Software, sprich der Hersteller, und nicht der Kunde, sprich die Behörden, weiß, wie die Software Entscheidungen trifft.

So auch im Fall Eric Loomis, der im Jahre 2013 für seine Beteiligung an einem Drive-by-Shooting im US-Bundesstaat Wisconsin verurteilt wurde. Der Prozessrichter stützte sich bei der Bemessung der Haftstrafe teilweise auf eine Risikoeinschätzung des Angeklagten. Diese Risikoeinschätzung wiederum wurde von der Compas-Software aufgrund von persönlichen Daten Loomis‘ und der Auswertung von Verhören ermittelt. Der Richter gab Loomis eine lange Haftstrafe, woraufhin dieser das Urteil anfocht mit der Begründung, die Risiko-Einschätzung des Algorithmus sei nicht nachvollziehbar. Im vergangenen Sommer entschied das Oberste Bundesgericht gegen Loomis: Dieses war der Meinung, der Output des Algorithmus sei ein ausreichendes Maß an Transparenz.

Weder in den USA noch in der EU gibt es derzeit Standards oder gesetzliche Vorgaben bezüglich der Kontrolle dieser Software-Produkte. In anderen Branchen wie bei Medikamenten wäre das undenkbar. In der EU wird ab Mai 2018 mit der General Data Protection Regulation erstmals zaghaft auch eine Rechenschaftspflicht für Algorithmen eingeführt. Dieser Mangel an Transparenz hat reale Konsequenzen. Der Wired-Autor Jason Tashea fordert deshalb ein Moratorium für den Einsatz von KI in der Risikoberechnung „bis Prozesse und Verfahren vorhanden sind, die eine sinnvolle Untersuchung dieser Instrumente ermöglichen“.

Foto: Federal Bureau of Investigation - https://multimedia.fbi.gov/large/3341, Gemeinfrei, Link

Lügendetektor der Zukunft

Der in dem Loomis-Urteil zum Ausdruck kommende naive Glaube an die Neutralität der Technik ist erstaunlich, hat aber eine lange Tradition, denkt man etwa an die jahrzehntelange Popularität von Lügendetektor-Ergebnissen. Ganz nebenbei: Es ist fraglich, ob KI-Software überhaupt höhere Trefferquoten erzielen kann. Mehrere Studien kommen zu dem Ergebnis, bei Compas’ geheimen deep-learning-Fähigkeiten handle es sich um Fake. In einer Studie wurden mit einem Algorithmus, der mit minimalen Daten wie Alter, Geschlecht und Vorstrafen einen Score errechnet, vergleichbare Ergebnisse erzielt. In einer anderen Untersuchung wurden 400 Freiwillige auf einer Crowdsourcing-Plattform mit der Aufgabe betraut, aufgrund weniger Daten eine Voraussage zu treffen. Ergebnis: Menschen, die über die Mechanical-Turk-Plattform von Amazon rekrutiert wurden, sagen Rückfälligkeit mit einer Genauigkeit von 67 Prozent voraus, verglichen mit 65 Prozent für Compas.

„The bigger the lie, the more they believe.”

Daniel Newman, Gründer und Principal Analyst von Futurum Research und einer der bekanntesten Experten für Digitalisierung des Justizwesens in den USA, ist noch ehrgeiziger. Er sieht eine Zukunft des maschinellen Lernens in der Behandlung von komplexeren Situationen. Sagt ein Zeuge die Wahrheit? Die Antwort auf diese Frage soll in Zukunft die Analyse von Bild- und Audiodaten liefern: Gesten, Stimmlage und Körperhaltung sollen im durch den Einsatz KI-gestützter Analyse-Tools ausgewertet werden – de facto eine Weiterentwicklung des Lügendetektors. Für Newman würde dieser Technologieeinsatz dazu beitragen, ein höheres Maß an Objektivität gegenüber den konventionellen Gerichten zu erreichen, die stärker von der emotionalen Seite der Parteien einer Klage beeinflusst werden.

Dem Lügendetektor hat die US-Serie „The Wire“ ein unsterbliches Denkmal gesetzt. In der Eröffnungsszene der fünften Staffel der in Baltimore angesiedelten Polizeiserie gelingt es Detective Bunk einem Verdächtigen ein Geständnis abzupressen, unter anderem mit einem gefälschten Lügendetektor-Test: Der Lügendetektor ist ein Kopiergerät, an den der Arm des Verdächtigen mit Gaffa-Tape befestigt wird, und dessen Papierreservoir mit drei Blättern, auf denen „wahr“, „wahr“ und „falsch“ steht, präpariert wurde. Bunks Fazit: „The bigger the lie, the more they believe.”

Quellen und Links

- Melvin Kranzberg, Technology and History: Kranzberg's Laws, Sage Journals, Technology and Culture.

- Will Knight, Forget Killer Robots — Bias Is the Real AI Danger, in MIT Technology Review, 3.10.2017

- The White House, Economic Perspectives on Incarceration and the Criminal Justice System, April 2016

- U.S. Department of Justice, Correctional Populations in the United States, 2015,

- Samantha Highfill, The Good Wife season 7 premiere recap: Bond, 5.10.2015,

- Javier DeCendra, Ya se puede automatizar la mitad de las tareas de un abogado, Vodafone Spanien, 4.1.2018

- Bettina Heintz, Die Herrschaft der Regel. Campus, Frankfurt am Main 1993

- Jon Kleinberg, Himabindu Lakkaraju, Jure Leskovec, Jens Ludwig, Sendhil Mullainathan, Human Decisions and Machine Predictions, National Bureau of Economic Research, NBER Working Paper No. 23180, Februar 2017

- Megan Garber, When Algorithms Take the Stand. A case soon to be decided by the Wisconsin Supreme Court considers the proper role of mathematical prediction in the courtroom—and beyond, The Atlantic, 30.6.2016

- Jason Tashea, Courts Are Using AI to Sentence Criminals. That Must Stop Now, Wired, 17.4.2017

- Matthias Spielkamp, Inspecting Algorithms for Bias, MIT Technology Review, 12.6.2017

- Ed Yong, A Popular Algorithm Is No Better at Predicting Crimes Than Random People, The Atlantic, 17.1.2018

- Daniel Newman, La inteligencia artificial quiere ser la nueva ‘máquina de la verdad’ en los juicios, Vodafone Spanien, 8.3.2018

Zur Übersicht aller bisherigen Texte der Reihe »Understanding Digital Capitalism«.