„Kunst aus dem Computer ist zuerst immer Zufall“Der KI-Forscher, Neurowissenschaftler und Musiker Henrik Jacobsen im Interview

26.2.2019 • Technik & Wissen – Text: Ji-Hun Kim, Illustration: Susann Massute

Wann werden Roboter und KIs so gut, um Musik und Kunst machen zu können wie Menschen? Geht das überhaupt? Wo liegen die eigentlichen Probleme im Verständnis von neuronalen Netzwerken und Machine Learning, und welche Rolle spielt Google dabei? Der KI-Forscher und Neurowissenschaftler Henrik Jacobsen arbeitet am Vector Institute und an der University of Toronto an diesen und vielen anderen Fragen, die die Menschheit derzeit brennend interessieren. Einige kennen Henrik Jacobsen aber auch als Co-Betreiber des Labels Doumen Records und durch seine Band Praezisa Rapid 3000. Eine seiner Fragestellungen lautet: Wie lassen sich Forschung und Musik näher zusammenbringen und welche Rolle spielen generative Modelle dabei? Wie diese scheinbar weit voneinander entfernten Themenbereiche zusammengehen, weshalb unsichere Maschinen besonders kompliziert sind und warum er keine Alexa bei sich zu Hause hat, erklärt er uns im ausführlichen Interview.

Erzähl doch zuerst was zu deinem Hintergrund.

Ich habe in Leipzig studiert. Dort haben wir das Label Doumen gegründet. Das lief Jahre lang ganz gut, wird aber immer schwieriger, weil wir alle so viel anderweitig zu tun haben. Man fragt sich durchaus, wie relevant das Veröffentlichen von Vinyl heute noch ist. Ich habe aber auch immer Forschung betrieben. Zunächst studierte ich Physik, habe dann im Bereich Neurowissenschaft und Musik geforscht und bin so schließlich zur Künstlichen Intelligenz gekommen. Meine Doktorarbeit schrieb ich dann in Amsterdam. Ein guter Zeitpunkt, die Deep-Learning-Revolution fand genau zu dieser Zeit statt. So konnte ich direkt in das Thema einsteigen. Einige ProfessorInnen dort waren ziemliche Koryphäen auf dem Gebiet und so fand ich ein spannendes Umfeld vor. Nach der Promotion war ich kurz in Tübingen, lebe und arbeite jetzt aber in Toronto.

Was ist dein Themenbereich?

Heute geht es ja darum, dass man nicht mehr explizit Programme schreibt. Beim Deep Learning können Algorithmen selber lernen, es ist eine spezielle Form von Machine Learning. Wie bei der Neurowissenschaft haben wir zwar zunächst ein Konstrukt mit Input und Output, wissen aber nicht genau, was dazwischen eigentlich passiert. Wie kommt der Algorithmus zu seiner Entscheidung? Bei solchen Algorithmen handelt sich um ein extrem simples Gehirn. Aber selbst da stellen wir fest, dass dieses enorm simplifizierte Gehirn Dinge macht, die wir in ihrer Gänze nicht verstehen. Für meine Doktorarbeit habe ich mich die meiste Zeit damit auseinandergesetzt, ob man Algorithmen gewisse Strukturen geben kann, die man besser interpretieren und auch analytisch besser verstehen kann.

Heute arbeitest du hauptsächlich an KI?

Genau. Die Frage lautet: Was lernt die Künstliche Intelligenz? Was hat sie bereits gelernt? Wie löst sie Aufgaben? Es stellt sich nämlich heraus, dass es Intelligenzen gibt, die narrow domain tasks besser lösen als Menschen. Zum Beispiel hunderte von Hundearten auseinanderhalten.

Oder Hautkrebs erkennen.

Auch. Aber dann sieht die KI plötzlich auf Bildern ein Hochhaus, auf denen wir eindeutig Hunde erkennen. Feinste Pixel-Änderungen können dafür sorgen, Algorithmen völlig aus dem Konzept zu bringen. Das eröffnet die Frage – wenn man diese Technologien anwenden will, beispielsweise in selbstfahrenden Autos: Sind wir wirklich schon so weit? Oder sollten wir erst besser verstehen, wie die Wahrnehmung solcher Systeme wirklich funktioniert?

Henrik Jacobsen vor einem KI-Labor an der Universität von Toronto. In diesen Gemäuern gelang Forschern 2012 der wesentliche Durchbruch im Bereich Deep Learning. Hier fing quasi der KI-Hype der letzten Jahre an.

Neurowissenschaftler sagen, dass wir das menschliche Gehirn heute maximal zu zehn Prozent verstehen und kennen. Und dennoch entstehen so große Hypes um Künstliche Intelligenzen. Das führt zu Trugschlüssen in der allgemeinen Wahrnehmung.

Das stimmt. Wir haben in der Tat ein sehr begrenztes Verständnis davon, wie unser Gehirn tatsächlich funktioniert. Gewisse Fortschritte im Bereich der KI und Bilderkennung haben mittlerweile jedoch Modelle produziert, um die neuronalen Aktivitäten in unserem Cortex besser zu verstehen. Man kann Deep-Learning-Algorithmen trainieren, Objekte in Bildern zu erkennen. Wir können dann diese Algorithmen nutzen, um neuronale Aktivitäten im menschlichen Gehirn vorherzusagen, die sich ergeben, wenn Menschen die selben Objekte wie der Algorithmus anschauen. Es gibt also statistische Zusammenhänge zwischen der Wahrnehmung im Algorithmus und unserem Gehirn. Das war für viele erstmal überraschend und es gab recht große Hoffnung, dass man dadurch das Gehirn besser verstehen könne. Dann stellte sich aber heraus, dass man eigentlich nur eine weitere Blackbox hat, die man auch nicht versteht, die aber statistische Vorhersagen treffen kann. Am Ende haben wir also noch immer kein Modell, das verstehen kann, was im Cortex genau bei der Wahrnehmung passiert, aber es ist immerhin ein Schritt vorwärts.

Ich erinnere mich an den Film über Alpha Go und den Meister Sedol Lee. Am Ende pflichtet er bei, von Algorithmen auch etwas für sein Spiel lernen zu können, um es auf ein noch höheres Level zu bringen.

Das ist eine der Hauptmotivationen, wieso ich in dem Bereich arbeite. Viele sehen es so, dass die Chance darin besteht, durch Algorithmen Regularitäten abzuleiten, die wir mit physikalischen Gesetzen nicht beschreiben können. Wenn man also einen Algorithmus trainiert, Go zu spielen, dann hat er im Falle eines Sieges gegen einen Großmeister Regularitäten festgestellt, die der Mensch vorher vielleicht noch nicht gefunden hat. Was dann noch fehlt ist, dass der Algorithmus erzählt, was er gefunden hat und es uns erklärt.

Wie funktioniert eigentlich Machine/Deep Learning? Dieses Video klärt auf.

Das geht noch nicht?

Die Frage ist, ob das je gehen wird. Es gibt führende Deep-Learning-Forscher, die sogar gegen die Idee der Interpretierbarkeit sind. Wir als Menschen können das nämlich auch nicht. Wenn ich dir eine 6 aufmale und du sagst mir: „Das ist eine 6.“ Dann frage ich dich auch nicht: „Warum ist das eine 6?“ Die Antwort würde schwerfallen. Du weißt, es ist eine 6. Aber wie soll man erklären, warum die 6 eine 6 ist? Was macht die 6 zu einer 6? Ich kann mir aber vorstellen, dass Algorithmen eher als wir das Potenzial haben, sich selber zu erklären. Man kann theoretisch Algorithmen schreiben, wofür man will. Ich denke an datenbasierte Theoriemaschinen. Der ferne Zukunftstraum ist, ein Newton’sches Gesetz nur mit Videos von runterfallenden Äpfeln ableiten zu können.

Für Big Data braucht man irrsinnige Quantitäten an Daten. Qualität scheint indes ein Wert, der im Kontext Deep Learning schwer vermittelbar ist. Ein Computer kann lernen, einen Tennisball zu erkennen. Aber sagen, was eine schöne oder weniger schöne Rückhand ist …

Das ist eines der großen Probleme. Was heute gut funktioniert: Maschinen zu trainieren, Dinge zu tun, die mit einem klaren Ziel definiert sind. Ist A oder B auf dem Bild zu sehen? Gehört die Verteilung der Bilder zu dem, was du schon mal gesehen hast? Ist das Bild daher realistisch? Was gut und schlecht ist, müsste man als Ziel definieren können. Dafür bräuchte man eine Datenbank, in der das jemand festlegt. Aktuell gibt es dafür aber keine Tools. Für einen Algorithmus, der von sich aus lernt, ästhetische Dinge zu tun, gibt es bislang keine mathematische Formulierung. Heißt, das kann man auch nicht trainieren.

Ein Computer müsste ja erkennen können: Heute habe ich ein besonders schönes Bild gemalt im Vergleich zu vorgestern.

Das kann er natürlich nicht. Am Ende erkennt der Forscher, ob etwas „besser“ aussieht. Metriken für Evaluierungen solcher Faktoren sind daher eine der großen Herausforderungen.

Im Bereich Consumer Electronics suggerieren Firmen wie Google, Amazon und Apple, dass KI mit Sprachassistenzen wie Alexa und Siri vollends für den Haushalt bereit ist. Was steckt wirklich dahinter?

Man kann KI in absehbarer Zeit in allen Bereichen anwenden, in denen sich klare Ziele definieren lassen. Wenn man ein riesiges Datenset hat, das Input und Output definiert, kann das robust funktionieren. Wird die Situation aber komplexer und kommen Variablen hinzu, die ein Algorithmus während des Trainings noch nie gesehen hat, muss ein großes Fragezeichen gesetzt werden. Der ganze Themenbereich des autonomen Fahrens scheint auf der Schwelle dazwischen zu sein. Man kann viele Daten erzeugen, und es fahren schon viele Autos herum, die Daten sammeln. Aber dann gibt es wiederum Umstände im Straßenverkehr, die nicht vorhersehbar sind. Dann ist sich ein Algorithmus nicht mehr sicher.

Diese Animation zeigt die schematische Klassifizierung von Fotos via Deep Learning. | Quelle: Becoming Human – Artificial Intelligence Magazine

Gerade beim autonomen Fahren muss es ein konkretes Framework geben.

Das Szenario Autobahn ist relativ realistisch. Spezialisten sind sich aber weiterhin nicht einig, wann das wirklich sicher und uneingeschränkt funktionieren wird. Ein Machine-Learning-Algorithmus, der dir sagen kann: Ich bin mir nicht sicher bei meiner Entscheidung – das ist gar nicht so einfach, wie sich herausgestellt hat. Also nochmal: Einfache Tasks mit eindeutigem Ziel, das sind die Bereiche, in denen KI Einzug halten wird. Amazon-Lagerhaus-Roboter zum Beispiel. Sachen, die nicht sensitiv sind: Fotos sortieren oder Werbung vorschlagen zum Beispiel, weil ein Fehler hier kein großes Problem darstellt. Google und Facebook profitieren ja genau in diesem Bereich von ihrer KI-Forschung. Die grundsätzliche Veränderung, in naher Zukunft ein wesenähnliches Etwas vor sich zu haben, sehe ich in den nächsten Jahren nicht kommen. Das wäre schon eine sehr fortgeschrittene Mustererkennung, die man sich aktuell einfach kaum vorstellen kann.

Hast du Alexa zu Hause?

Nein.

Wieso nicht?

Ich habe Probleme damit, mich der Sache so zu öffnen. In meinem Feld ist es ja so: Wenn Google KI-Forscher fragt, ob sie bei Google arbeiten möchten, sagen die meisten ja und sind weg. Da können sie sich zuvor noch so subversiv dargestellt haben. Das ist in anderen Bereichen natürlich auch so, aber der Schwund war in unserem Bereich riesengroß. Ich habe meine Doktorarbeit Anfang 2013 angefangen und in den Jahren danach war das ein richtiger Boom – beinahe jeder Professor hat sein Start-up an ein großes Unternehmen verkauft. Ich konnte mir nicht recht vorstellen, bei einer der ganz großen Datenfirmen zu arbeiten, und habe für mich einen Mittelweg gefunden: Ich arbeite für ein Non-Profit-Unternehmen, das mit der hiesigen Uni sehr eng verbunden ist. Deshalb habe ich auch keine Alexa zu Hause. Ich nutze auch kein WhatsApp.

Da spielen Datenschutzgründe eine vorangestellte Rolle.

So in etwa. Hast du Alexa?

Nein. Mir erschließt sich der Mehrwert nicht.

Zurzeit gehen die Leute eher zu Google, weil die sich besser darstellen als Facebook. Amazon ist sowieso ein bisschen unbeliebt, auch weil sie ihre Forschungsergebnisse nicht öffentlich publizieren wollen. Aber man muss natürlich genauso hinterfragen, ob Google nicht einfach nur die bessere Marketingstrategie fährt. Ein Großteil der Superstars aus dem Feld der Künstlichen Intelligenz sitzt mittlerweile bei Google.

„Es ist ein Wahnsinn, wie viele KI-Forscher gerade zu Google gehen.“

Sind diese Stars überhaupt noch in der Lehre tätig?

Nein.

Aber spätestens dann haben wir doch ein gesellschaftliches Problem, wenn junge KI-Forscher nicht mehr bei den Besten lernen können …

Das ist ein großes Problem. Es ist nicht schwierig, Doktoranden zu finden. Aber zwischen Doktorand und Professor gibt es ja einige Stufen. Post-Docs zu finden, die gut sind, ist sehr schwierig. Zur Zeit gehen eigentlich alle direkt in die Industrie. Die Leute strömen da auch hin, um noch Geld zu verdienen. Unter Umständen könnte diese Blase ja in ein paar Jahren auch wieder platzen. Danach kommen die bestimmt alle wieder zurück an die Uni. Das ist zumindest mein Gefühl. Es ist ein Wahnsinn, wie viele gerade zu Google gehen. Seit es bei Facebook kriselt, sind von dort auch wieder viele zu Google abgewandert.

Weißt du, was sie vorhaben?

Es ist divers. Es gibt so viele Leute, die dort arbeiten. Was man Google zugute halten muss ist, dass Code produziert und in Papers aufgeschrieben wird. Zum größten Teil wird das Wissen der Öffentlichkeit und der akademischen Forschung zugänglich gemacht. Auf der anderen Seite müssen die das machen, weil sonst die Top-Forscher nicht kämen. Die wiederum müssen ja konstant publizieren, weil sie sonst wieder von der Landkarte verschwinden. Die Wenigsten wollen ihre akademische Karriere verwirken. Google hat außerdem auch ganz andere Kapazitäten und Rechnerleistungen als Unis.

Noch ist die Vinyl die erste Wahl für Labelbetreiber Henrik. Hier hält er die aktuelle EP von Abe in der Hand. Wie allerdings in Zukunft das Label Doumen Musik veröffentlichen will, wird derzeit noch ausgefuchst.

Ich wurde kürzlich gefragt, wann KI das Musikmachen völlig dem Menschen entziehen werden. Ich sagte: Niemals! Vielleicht etwas romantisch. Wie sieht deine Antwort aus?

Es kommt sehr auf die Form an. Ich denke, dass Stock-Music in ein paar Jahren so ein Bereich sein könnte, wenn es nicht schon längst so ist. Mir ist mal eine Firma in London aufgefallen, die anbot, deine hochgeladenen Videos mit durch Algorithmen angepasste Musik zu versehen.

Praktisch!

Wenn dein Job als Komponist ist, bestehende Musik abzuwandeln, damit sie royalty free ist und auf dein Video passt, dann ist die Herausforderung überschaubar und kann wahrscheinlich von Maschinen erlernt werden. Es ist ja eher eine Imitation mit einer leichten Abwandlung. Aber das, was Musik als Kunst ausmacht, das kann ich mir nicht vorstellen. Du brauchst ja immer den Kurator. Sobald Computer Bilder oder Musik generieren, wird jemand gebraucht, der sagt: Das ist interessant, das nehmen wir jetzt.

Vielleicht ist die Frage, ob ein Computer Musik schaffen kann, auch eine philosophische. Du hast damals in Leipzig zu einem musikalischen Thema gearbeitet.

Am Max-Planck-Institut habe ich geforscht, ob es neuronale Grundlagen dafür gibt, warum an Alzheimer Erkrankte so gut Musik erinnern können, sich aber mit anderen Dingen schwer tun. Damit habe ich mich eine ganze Weile beschäftigt.

Wie lautet die Antwort?

Die kurze Antwort: Wir können uns vorstellen, dass Musik wie ein komplexer Bewegungsablauf funktioniert. Das können Alzheimer-Patienten generell besser. Musik ist keine autobiografische Erinnerung, sondern eher wie Fahrradfahren.

Wie kann es sein, dass ausgerechnet die Musik so eine Rolle im Gehirn spielt?

Das Musizieren selbst hat ja auch viel mit Bewegung zu tun. Die Neurowissenschaft kann heute jedoch wenig definitive Antworten geben. Wir haben Belege und Hypothesen gefunden und andere widerlegen können. Letztendlich ist das alles jedoch sehr vage.

Mangelt es da an Geldern?

Nein, es mangelt am grundlegenden Verständnis darüber, wie das Gehirn funktioniert. Wir können anhand von statistischen Tests feststellen, dass Informationen in gewissen Gehirnarealen verarbeitet werden. Wir wissen aber lange noch nicht, welche Information das jetzt ist und welche Rolle sie genau spielt. Da kommt man nicht weiter. Fest steht nur: Es gibt eine Region, die hat Relevanz für musikalische Erinnerung und wird erst spät von Alzheimer zerstört. Aber welche genau, ist reine Interpretationssache. Das war auch der Grund, wieso ich den Bereich verlassen habe.

Die Zeit und der Fortschritt könnten Antworten liefern?

Hoffentlich. Letztendlich gibt es beim Machine Learning das gleiche Problem. Hier hat man sogar genauen Zugriff auf einzelne Neuronen, und trotzdem versteht man die Informationsverarbeitung nicht wirklich.

Weil nicht mal der Mensch weiß, was Musik genau ist.

Genau.

„Diese Algorithmen können eine ganz eigene Ästhetik schaffen. Es braucht aber den starken Einfluss des Künstlers, der an den Einstellungen der Algorithmen dreht, Bilder auswählt und so fort. Er kann zwar das Endergebnis nicht vollständig beeinflussen, aber den Kontext.“

Während meines Studiums haben wir Musik als intentionale Klangerzeugung in einem zuvor definierten Zeitrahmen definiert. Das schließt dann John Cages „4:33“ mit ein, Hintergrundrauschen aber wiederum aus. Auch experimentelle Musik kann man mit dieser Definition ganz gut einordnen. So ließe sich zwar Musik definieren, aber das sagt noch lange nichts über die Ästhetik aus.

Sobald man ein klares Ziel definieren kann, was bei Stock-Music so wäre, bekommt man 100.000 Versionen des einen Hans-Zimmer-Soundtracks, den es ja auch schon so oft gibt. Aber kreative Neuerungen und die kulturelle Interaktion, die Musik ausmachen – für solch einen Kontext hat ein Algorithmus keinerlei Verständnis. Der Kontext müsste in den Daten stecken, die ihn trainieren. Die müssten sehr gut kuratiert sein, und da kommt wieder der Kurator ins Spiel. Ich sehe folgendes als nächste Stufe: Eine DAW oder einen Sequencer, die mit sowas arbeiten. Das kann ich mir gut vorstellen. Also neue Tools, mit denen man abstrakte Ebenen erreichen kann, die man so bislang nicht ohne weiteres erreichen konnte.

Wie kann das aussehen?

Man stelle sich vor, man kreiert ein paar Takte mit einem Algorithmus, dann könnte man mit diesen Tools vielleicht den Stil ändern. Oder ein Beispiel eingeben, wie der gewünschte Stil klingen soll. So etwas in der Richtung kann ich mir vorstellen. Der Künstler Mario Klingemann macht so etwas mit Bildern. Er generiert mit Hilfe von KI Bilder, die sehr obskur sind und es heute auch schon in Galerien schaffen. Diese Algorithmen können eine ganz eigene Ästhetik schaffen. Es braucht aber den starken Einfluss des Künstlers, der an den Einstellungen der Algorithmen dreht, die Bilder auswählt. Er kann zwar das Endergebnis nicht vollständig beeinflussen, aber den Kontext.

Der Münchener Künstler Mario Klingemann macht seit 25 Jahren mit Algorithmen Kunst. Im März werden einige seiner Werke bei Sotheby's versteigert. Erwartet werden Preise zwischen 35.000 und 46.000 Euro pro Gemälde.

Kommt die Kunst oder die Musik überhaupt ohne so eine Autoren-Künstler-Persona aus?

Das ist eine wichtige Frage. Selbst wenn es eine KI gibt, die wahnsinnig gute Musik macht: Würde man das überhaupt noch als Musik wahrnehmen? Es würde sich anfühlen wie ein Zufall. Letztendlich ist es auch ein Zufall. Denn wir reden von statistischen Systemen. Ich sehe da unterschiedliche Herausforderungen. Eine Handvoll MIDI-Noten zu generieren, ist eine Sache. Aber komplexe Zusammenhänge über detaillierte Texturen zu schaffen, stelle ich mir ungemein schwierig vor. Gerade repetitive Musik arbeitet viel mit dem Zusammenspiel von Texturen und kleinen Brüchen. Ich sehe in KI eher das Potenzial, hervorragende Tools für Menschen zu schaffen.

Einer eurer Artists, Abe, hat mit solchen Themen bereits gearbeitet.

Abe ist ursprünglich aus Amsterdam und hat lange im Muiziekgebouw gearbeitet. Sein Vater ist dort der Nachtwächter. Er selbst hat dort eine große Begeisterung für Minimal Music, Terry Riley und so entwickelt. Vor zwei Jahren gab es ein Projekt von Google namens Wavenet – einen Algorithmus, der es erstmalig geschaffen hat, dass man kaum noch unterscheiden konnte, ob das Audiomaterial generiert oder aufgenommen wurde. Heute kommt diese Technik beim Google Assistant zum Einsatz, wenn auch eher im Bereich der Sprachsynthese. Daraus hat Abe viele Samples benutzt. Er hat das als Dialog gesehen zwischen ihm und den Maschinen. Man kann die Sprachsynthese aber auch ohne Text antriggern. Es klingt wie Sprechen, es ist aber kein Wort dabei.

Nutzt du selber solche Technologien für deine Musik?

Die Frage ist halt immer die Kontrolle. Wenn man das nur als Sampler benutzt, kann man das machen. Bei generativen Modellen ist das aber schwierig. Das Generierte konkret zu kontrollieren, ist nicht leicht.

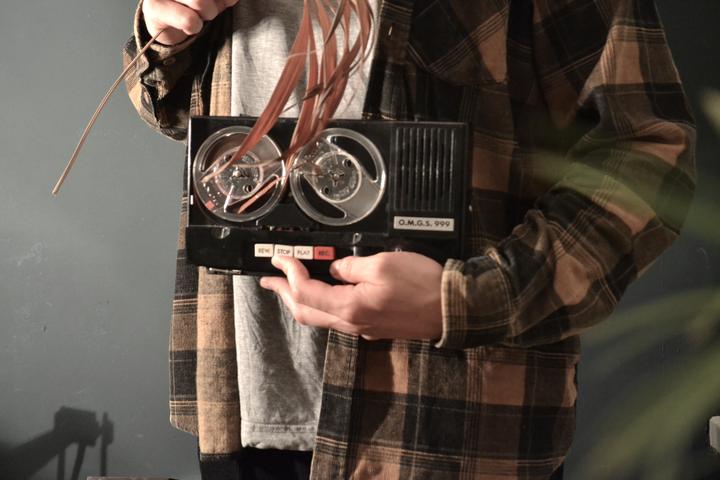

Der niederländische Künstler Abe ist eher fotoscheu, mag dafür Algorithmen als Klangquelle, trockene Tropenpflanzen und Tapegeräte.

Was sind generative Modelle?

Algorithmen, die ohne Labels oder Ziele trainiert werden. Sie lernen zu erkennen, ob Daten echt sind oder nicht. Daraufhin lernen sie Daten zu generieren, die wie die echten Daten sind. Nachdem man sie trainiert hat, kann man neue Daten generieren, die wie das sind, was sie gesehen haben, aber nicht das Gleiche. So kann man Interpolation betreiben. Einen ähnlichen Ansatz verfolgt das Google-Device NSynth. Bei generativen Modellen geht es darum, zu lernen, Daten zu produzieren, die nicht mehr von echten Daten zu unterscheiden sind. Dadurch entsteht ein Raum abstrakter Repräsentationen von diesen Daten, und mit diesen Daten kann man Details manipulieren, auf die man vorher keinen Einfluss hatte. Stil, musikalische Eigenschaften …

Ist das wie Melodyne?

Eigenschaften wie ein Musikstil sind abstrakt, weil es keine linearen Daten sind. Die Gründe warum ein Instrument so klingt wie es klingt, finden sich im Audiomaterial selbst. Melodyne war da ein erster Schritt. Die Modelle von heute können aber viel weiter gehen.

Googles erster Synthesizer NSynth kreiert Klänge auf Basis von Algorithmen.

Wie geht es mit dem Label weiter?

Wir überlegen weg vom Vinyl zu gehen, hin zu was Neuem. Durchaus möglich, dass wir uns da mehr mit algorithmischer Komposition beschäftigen. Das ist im Werden, und ich bin noch nicht sicher über die Form. Ich denke etwa an Multimedia-Produktionen, die auch online stattfinden. Das physikalische Medium hat seinen Reiz verloren, weil es so ausdefiniert ist. Es ist ein Produkt im besten Sinne geworden. Alle wissen, wie man eine Platte produziert. Bei generativer Musik gäbe es ja Ansätze, die nie aufhören. Ich könnte ein Stück produzieren für eine Webseite, und die hört nie auf zu spielen. Wavepaths, wo auch Brian Eno mitgewirkt hat, ist ein spannendes Beispiel dafür, was man mit generativer Musik machen kann. Man kann Content produzieren, aber auf eine sehr reduzierte Weise. Das finde ich faszinierend.

Als die erste iPad-Welle losging, haben viele Musiker Apps statt Alben herausgebracht. So richtig weiter entwickelt hat es sich seither nicht, oder doch?

Es braucht Künstler, die genau das können. Nicht die, die eigentlich Songs schreiben und sich an der Software ausprobieren wollen. Es braucht vielmehr Leute, die mit all dieser Technologie aufwachsen und damit neue Wege gehen, die wir uns jetzt noch nicht vorstellen können. Ob das jetzt generativ sein muss, ist eine andere Frage. Ich fand es interessant, dass Abe einen Algorithmus zur Klangquelle auserkoren hat. Das scheint banal, ist aber eine interessante Richtung.

Ist Musik unter KI-Forschern ein Thema?

Weniger. Viele Forscher haben einen fürchterlichen Geschmack. Ich frage mich immer wieder: Wie kann jemand so in einem Bereich spezialisiert sein und dann nur Mainstream hören (lacht)? Das wundert mich schon. Meistens ist der gute Musiker kein guter Forscher und umgekehrt.

Weil Musiker nicht genau genug arbeiten?

Eher weil man schon viel Zeit braucht, um eine Sache alleine gut hinzubekommen. Und weder Musik noch Forschung sind einfache Dinge, die man eben so nebenbei macht.